Meta veröffentlicht den Code im Open-Access-Bereich Künstliche Intelligenz unter dem Namen Bildbinden, das Beziehungen zwischen Daten vorhersagt, ähnlich wie Menschen ihre Umgebung wahrnehmen oder sich vorstellen. Während Bildgeneratoren wie Midjourney, Stable Diffusion und DALL-E 2 Wörter an Bilder binden und es Ihnen ermöglichen, visuelle Szenen nur auf der Grundlage einer Textbeschreibung zu erstellen, geht ImageBind darüber hinaus. Es kann Text, Bilder oder Video, Audio, 3D-Messungen, Temperaturdaten und Bewegungsdaten verknüpfen – und das, ohne dass bei jeder Gelegenheit eine Vorschulung erforderlich ist. Dies ist ein frühes Stadium eines Frameworks, das schließlich in der Lage sein wird, komplexe Umgebungen aus einfachen Eingaben wie einer Textaufforderung, einem Bild oder Audio (oder einer Kombination davon) zu generieren.

Sie können sich ImageBind als eine Annäherung des maschinellen Lernens an das menschliche Lernen vorstellen. Wenn Sie sich beispielsweise in einer dynamischen Umgebung wie einer belebten Stadtstraße befinden, nimmt Ihr Gehirn (meist unbewusst) Anblicke, Geräusche und andere Sinneseindrücke auf, um Informationen über vorbeifahrende Autos, hohe Gebäude, das Wetter und mehr zu erhalten . Menschen und andere Tiere haben sich so entwickelt, dass sie diese Daten für unsere genetischen Vorteile verarbeiten: Überleben und Weitergabe unserer DNA. (Je mehr Sie über Ihre Umgebung wissen, desto besser können Sie Gefahren vermeiden und sich an Ihre Umgebung anpassen, um besser zu überleben und zu gedeihen.) Je näher Computer der Nachahmung der multisensorischen Verbindungen von Tieren kommen, desto mehr können sie diese Verbindungen nutzen, um vollständig realisierte Szenen zu erzeugen, die nur auf begrenzten Datenmengen basieren.

Während Sie also Midjourney möglicherweise verwenden, um „einen Basset in einem Gandalf-Kostüm zu erstellen, der auf einem Wasserball balanciert“ und ein relativ realistisches Foto dieser seltsamen Szene zu erhalten, erstellt ein multimodales KI-Tool wie ImageBind am Ende möglicherweise ein Video mit dem Hund mit Relevanz Geräusche, einschließlich eines detaillierten Wohnzimmers, der Raumtemperatur und der genauen Position des Hundes und aller anderen Personen in der Szene. „Dadurch entsteht eine hervorragende Möglichkeit, Animationen aus statischen Bildern zu erstellen, indem diese mit Audio-Eingabeaufforderungen kombiniert werden“, stellen die Meta-Forscher in ihrem entwicklerorientierten Blog fest. „Zum Beispiel kann ein Ersteller ein Bild mit einem Wecker und einem krähenden Hahn kombinieren und einen Audio-Hinweis verwenden, um den Hahn zu segmentieren, oder den Ton des Weckers, um die Uhr zu segmentieren und beide in einer Videosequenz zu animieren.“

Was sonst noch mit diesem neuen Spielzeug gemacht werden kann, weist eindeutig auf eines der Kernambitionen von Meta hin: VR, Mixed Reality und Metaspace. Stellen Sie sich zum Beispiel ein zukünftiges Headset vor, das im Handumdrehen vollständig realisierte 3D-Szenen (mit Ton, Bewegung usw.) erstellen kann. Oder Entwickler virtueller Spiele könnten sich damit irgendwann einen erheblichen Teil der mühsamen Arbeit im Designprozess ersparen. Ebenso könnten Inhaltsersteller immersive Videos mit realistischen Soundtracks und Bewegungen erstellen, die nur auf Text, Bildern oder Audio basieren. Man kann sich auch leicht vorstellen, wie ein Tool wie ImageBind neue Türen in der Barrierefreiheit öffnet, indem es in Echtzeit Multimedia-Beschreibungen generiert, um Menschen mit Seh- oder Hörbehinderungen dabei zu helfen, ihre Umgebung besser zu verstehen.

Auch interessant: Die besten Tools basierend auf künstlicher Intelligenz

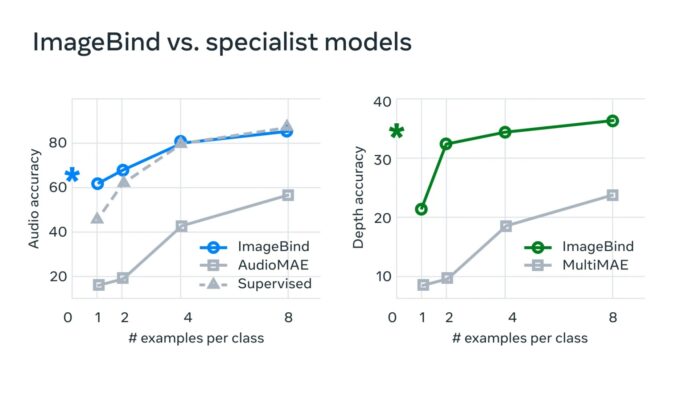

„In typischen KI-Systemen gibt es für jede relevante Modalität eine spezifische Einbettung (d. h. Zahlenvektoren, die Daten und ihre Beziehungen beim maschinellen Lernen darstellen können)“, sagt Meta. „ImageBind zeigt, dass es möglich ist, einen gemeinsamen Einbettungsraum für mehrere Modalitäten zu schaffen, ohne mit jeder einzelnen Kombination von Modalitäten Daten trainieren zu müssen. Dies ist wichtig, da Forscher keine Datensätze mit Proben erstellen können, die beispielsweise Audiodaten und Wärmedaten einer belebten Stadtstraße oder Tiefendaten und eine Textbeschreibung einer Klippe am Meer enthalten.“

Meta glaubt, dass diese Technologie irgendwann sozusagen über die derzeitigen sechs „Sinne“ hinausgehen wird. „Obwohl wir in unserer aktuellen Studie sechs Modalitäten untersucht haben, glauben wir, dass die Einführung neuer Modalitäten, die möglichst viele Sinne verbinden – wie Berührung, Sprache, Geruch und fMRT-Gehirnsignale – umfassendere, auf den Menschen ausgerichtete KI-Modelle ermöglichen wird.“ Entwickler, die diese neue Sandbox erkunden möchten, können zunächst in den Open-Source-Code von Meta eintauchen.

Lesen Sie auch: